A História do Big Data

Big Data é apenas um termo novo que agrega tecnologia para algo que sempre foi feito: analisar grande quantidade de dados. O termo "grande" é relativo, afinal, quando uma pessoa pega informações como nome, curso, CPF e outros de estudantes de uma universidade com 5.000 alunos, sem dúvidas, é uma ENORME quantidade de dados para uma pessoa só. E, assim, vem seus primeiros sinais na história, junto também, com o quão importante os dados são.

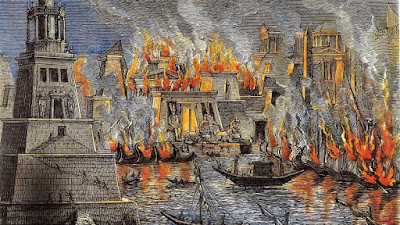

Dados são de suma importância para tirar conclusões, logo não devem ser jogados fora, muito menos perdidos na rede. Se tratando de história, temos consequências da perda de dados, por exemplo, quando foi queimada a Biblioteca de Alexandria. Localizada no Antigo Egito, o local era um dos maiores centros de "armazenamento de dados" da Antiguidade que, se não tivesse sido queimado, que tipo de conclusões nos traria? Se analisarmos bem, vemos que a biblioteca possui Volume, Variedade (texto,relatos,desenhos), Veracidade (pelo menos, em boa parte dos escritos) e se, caso os seus arquivos estivessem vivos, poderiam ser analisadas de maneira veloz (com uso de diversos especialistas da área) e, sem dúvidas, nos traria valor. Então, se isso tivesse sido feito poderíamos dizer que foi um sinal do conceito de Big Data, mas, infelizmente, isso não o aconteceu.

Então, onde aconteceu a primeira vez que foi dito sobre analisar dados volumosos? Bem, não dá pra se dizer ao certo por se tratar de algo muito antigo. Mas, ele foi visto de maneira mais escancarada em 1663, quando o demógrafo Jonh Graunt realizou os primeiros experimentos do

que viria a ser a estatística. Ele criou um método para calcular as

mortes da peste bubônica que assolava a Europa se utilizando de dados de diversas fontes para seu estudo.

Em muitos momentos da história o Big Data mostrou suas caras de maneira disfarçada e uma trajetória da linha do tempo completa foi feita pelo World Economic Forum (o link será o primeiro dentre as fontes). Mas, quando ele foi se tornando mais próximo do que conhecemos atualmente?

Um dos primeiros Centro de Dados foi criado em 1965 pelos EUA, com o objetivo de controlar o pagamento de impostos e as impressões digitais dos americanos, relacionando esses dados, vemos a variedade e, se tratando de toda população estadunidense, vemos seu volume. Os mesmos eram bancos de dados centralizados, ou seja, uma mesma máquina era responsável pelo uso, armazenamento e análise dos dados, tal como um único algoritmo é responsável por todo o trabalho no Big Data? Coincidência? Óbvio que não.

Foi daí que surgiu a fagulha mais acentuada do enorme fogaréu que se tornaria o Big Data

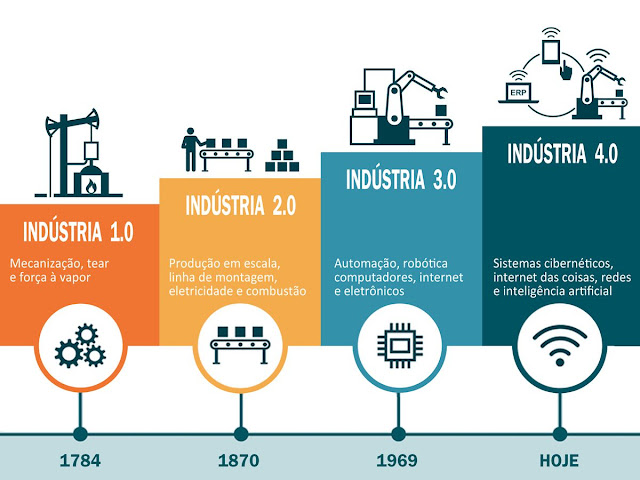

Após formado seu conceito personificado como algoritmo. Ocorreram fases do seu uso, também chamada de "onda". Na primeira, até mesmo por se tratar de novidade surgindo e pelo armazenamento ser centralizado, acabou sendo caro e pouco utilizado. Então, como dizem, quando uma tecnologia evolui, outras a acompanham e com criação de sistemas descentralizado, juntamente ao barateamento do armazenamento, a ferramente se tornou mais acessível e foi explorada de mais formas, a fim de procurar múltiplas aplicações. Hoje, já vivemos uma fase em que podemos encontras Big Data em quase tudo que fazemos na internet, e seu uso é, a maioria das vezes, utilizado a nosso favor.

Mas então, como será a quarta onda?

Fontes:

Para fins de curiosidade: A história da Biblioteca de Alexandria e Sobre sua Destruição

Por: Letícia Silveira Martins

Por: Letícia Silveira Martins

Comentários

Postar um comentário